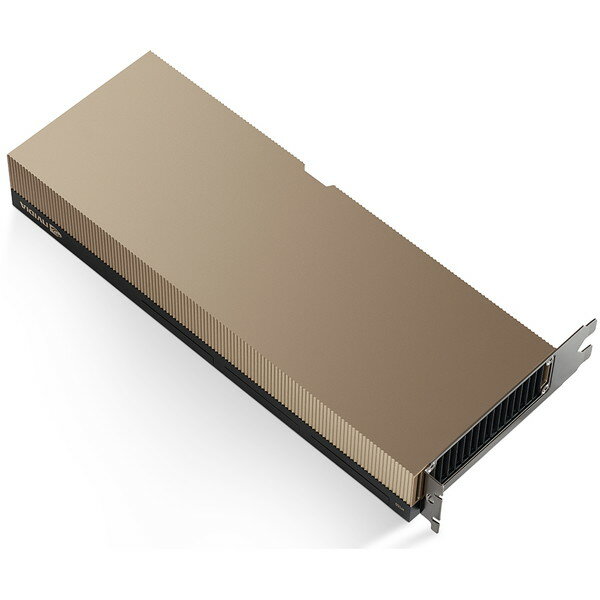

【1位交代】【4/5限定!エントリー&抽選で最大100%Pバック】NVIDIA NVH100-80G [グラフィックボード](楽天リアルタイムランキング)

楽天のリアルタイムランキングの首位が交代しました。新しい1位は、以下の通りです。

大幅な値下がり、ポイント還元率の大幅アップ、お得な割引クーポンの配布などによって順位が押し上げられいると考えられますので、売り切れる前にリンク先で詳細を確認してください。

調査日時:2024年04月06日 06時40分

商品説明★ アクセラレーテッド コンピューティングの大きな飛躍NVIDIA H100 Tensor コア GPU で、あらゆるワークロードのためのかつてない性能、拡張性、セキュリティを手に入れましょう。NVIDIA NVLink Switch System により、最大 256 個のH100を接続し、エクサスケールのワークロードを高速化できます。さらに、専用の Transformer Engine を利用することで、パラメーターが兆単位の言語モデルを実装できます。H100の複合的な技術革新により、大規模な言語モデルが前世代と比較して30倍も高速化され、業界の一歩先を行く対話型AIが可能となります。★ 大規模言語モデル推論を加速最大1750億 パラメーターの大規模言語モデル (LLM) の場合、PCIe ベースの H100 NVL with NVLink ブリッジは、Transformer Engine、NVLink、および 188GB HBM3 メモリを利用して、あらゆるデータ センターで最適な性能と容易な拡張性を提供し、LLM を主流にしています。H100 NVL GPU を搭載したサーバーは、電力制約のあるデータ センター環境において低遅延を維持しながら、GPT-175B モデルの性能を NVIDIA DGX A100 システムの最大 12 倍まで向上します。★ NVIDIA AI Enterprise標準サーバー向けの H100 には、NVIDIA AI Enterprise ソフトウェア スイートのサブスクリプション5年分 (エンタープライズ サポートなど) が付属しており、その非常に優れた性能によって AI を簡単に導入できます。それにより、企業や組織は、AI チャットボット、レコメンデーション エンジン、ビジョン AI など、H100 で高速化する AI ワークフローを構築するために必要な AI フレームワークおよびツールが活用できるようになります。スペック* アーキテクチャ:Hopper* GPUメモリー:80GB HBM2e* メモリー帯域:2TB/s* エラー修正コード(ECC):Yes* FP64:26TFLOPS* FP64 Tensor Core:51TFLOPS* FP32:51TFLOPS* TF32 Tensor Core:756TFOLPS* BFLOAT16 Tensor core:1513 TFLOPS* FP16 Tensor Core:1513 TFLOPS* FP8 Tensor Core:3026 TFLOPS* INT8 Tensor Core:3026 TFLOPS* デコーダー…・7 x NVDEC・7 x JPEG* インターコネクト…・PCIe5.0 128GB/s・NVLink: 600GB/s* 消費電力(TDP):300-350W* 冷却機構:パッシブ* フォームファクタ…・267.7 x 111・ Dual Slot* マルチインスタンスGPU(MIG):10GBのMIGが最大7つ

a-price:11156649